Оптимизация энергоэффективности: ключевое направление в проектировании будущих SoC

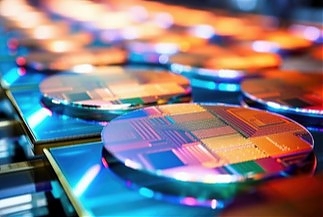

Развитие технологий полупроводников сталкивается с рядом серьёзных вызовов, связанных как с фундаментальными физическими ограничениями, так и с экономическими аспектами производства. Одной из ключевых проблем на современном этапе стала литография — процесс формирования микроскопических структур на подложке полупроводникового кристалла.

Традиционные методы фотолитографии, такие как глубокий ультрафиолет (DUV), уже приближаются к своим физическим пределам. Для того чтобы продолжать уменьшать размер транзисторов и повышать плотность компонентов на чипе, необходимы новые методы, такие как экстремальная ультрафиолетовая литография (EUV). Тем не менее внедрение EUV требует значительных капитальных вложений и технических новшеств, что существенно увеличивает стоимость производства.

Кроме того, физические свойства самих устройств становятся серьезным ограничением для дальнейшего масштабирования. Чем меньше становятся транзисторы, тем более выраженными становятся проблемы, связанные с утечками тока, управлением теплом и нежелательными квантовыми эффектами, такими как туннелирование электронов через барьеры, которые раньше считались непреодолимыми. Эти проблемы особенно остро встают при попытке снизить размер транзисторов ниже 3 нанометров.

На протяжении последних четырёх десятилетий полупроводниковая индустрия совершила значительный скачок благодаря постоянному улучшению архитектур вычислительных систем, оптимизации памяти и межсоединений. Эти достижения привели к созданию экзафлопсных вычислительных систем, которые обладают огромной вычислительной мощностью, способной выполнять квинтиллионы (10^18) операций в секунду. Это стало возможным благодаря масштабированию КМОП-технологий (комплементарные металлооксидные полупроводники), где за счёт уменьшения размеров транзисторов удавалось не только увеличивать количество транзисторов на единицу площади, но и улучшать энергоэффективность чипов.

Однако дальнейшее масштабирование КМОП сталкивается с существенными экономическими и технологическими барьерами. С каждым новым поколением техпроцесса стоимость разработки и производства чипов значительно возрастает. Особенно это касается высокотехнологичных фабрик, необходимых для производства микросхем с использованием новых методов литографии, таких как EUV.

Дополнительно к этому, растут и физические ограничения: достижение размера транзисторов менее 5 нанометров сопряжено с новыми проблемами, такими как снижение надежности, ухудшение производительности на уровне отдельных транзисторов и необходимость применения новых материалов, таких как нанолисты или 2D-материалы.

Ограничения по размеру кристаллов чипов также представляют собой серьёзную проблему. На данный момент предел физического размера кристалла ограничен примерно 826 мм². Превышение этого размера приводит к значительному снижению выхода годных изделий, так как вероятность появления дефектов на больших кристаллах значительно выше. Это препятствует увеличению не только площади, но и функциональности чипов, поскольку разработчики вынуждены искать новые способы интеграции сложных систем на одном кристалле при сохранении минимального числа дефектов.

Переход к системам масштаба zeta

Будущее вычислительных систем действительно движется к созданию систем масштаба zeta, которые обещают быть в 1000 раз мощнее современных экзафлопсных систем. Zettaфлопсные системы будут способны выполнять 10^21 операций в секунду, что откроет совершенно новые горизонты в области научных расчетов, моделирования, искусственного интеллекта и обработки больших данных. Однако для реализации таких систем потребуется преодоление ряда существенных технологических и инфраструктурных препятствий.

Одной из самых острых проблем, стоящих перед разработчиками zettaфлопсных систем, является их колоссальная потребность в энергии. Прогнозы указывают, что одна такая система будет потреблять около 500 мегаватт, что составляет примерно половину мощности средней атомной электростанции. Это сравнение подчёркивает, насколько серьёзными будут требования к энергетическим ресурсам, чтобы поддерживать работу этих сверхмощных вычислительных устройств. Для сравнения, экзафлопсные системы, такие как те, что разрабатываются сегодня, уже требуют сотни мегаватт, но zettaфлопсные системы выйдут на совершенно новый уровень энергопотребления.

Это ставит перед инженерами и учеными задачу не только по созданию более мощных вычислительных систем, но и по кардинальному повышению их энергоэффективности. Даже современные экзафлопсные системы сталкиваются с ограничениями по мощности, что делает их эксплуатацию дорогостоящей и сложной. В случае zettaфлопсных систем подобные ограничения могут стать критическими, если не будут разработаны инновационные решения, способные значительно снизить энергопотребление при увеличении производительности.

Одним из ключевых направлений решения проблемы может стать развитие систем-на-кристалле (SoC — System-on-Chip). Такие системы интегрируют все необходимые вычислительные компоненты — процессоры, графические чипы, контроллеры памяти и другие функциональные блоки — на одном кристалле. Это позволяет существенно улучшить энергопотребление за счёт уменьшения длины межсоединений, что снижает потери энергии при передаче данных между компонентами. Важно отметить, что энергоэффективность SoC напрямую зависит от инноваций в архитектуре и новых материалов, которые способны обеспечить как меньшую плотность энергопотребления, так и более эффективное управление тепловыми потоками.

Развитие SoC должно идти рука об руку с применением новых типов памяти, таких как MRAM (магниторезистивная память) и FRAM (ферроэлектрическая память), которые потребляют меньше энергии по сравнению с традиционными DRAM и SRAM. Кроме того, оптимизация методов передачи данных между процессорами и памятью, такие как 3D-структуры кристаллов и использование оптических интерконнектов, способна значительно снизить энергопотребление на уровне системы.

Одной из перспективных областей исследований является использование гетерогенных вычислительных архитектур, где различные типы процессоров (например, центральные процессоры, графические процессоры и специализированные ускорители для ИИ) работают в тандеме. Такая интеграция позволяет распределить задачи между устройствами, которые лучше всего подходят для их выполнения, что увеличивает общую энергоэффективность.

Кроме того, особое внимание должно быть уделено программным решениям, которые помогут максимизировать использование вычислительных мощностей при минимальном энергопотреблении. Оптимизация алгоритмов и управление задачами в реальном времени может существенно сократить затраты на энергопотребление.

Эволюция масштабирования КМОП

На ранних этапах развития полупроводниковых технологий масштабирование КМОП (комплементарных металлооксидных полупроводников) стало основным способом увеличения производительности микропроцессоров. Суть этого метода заключалась в постоянном уменьшении размеров транзисторов, что позволяло размещать большее их количество на одной и той же площади кристалла. Чем больше транзисторов можно было интегрировать на кристалл, тем выше становилась производительность, так как можно было обрабатывать больше данных за меньшее время. Кроме того, уменьшение размеров транзисторов снижало их энергопотребление, что способствовало увеличению скорости работы без значительного роста тепловыделения.

Масштабирование КМОП позволило индустрии двигаться в русле так называемого закона Мура, согласно которому количество транзисторов на микросхеме удваивалось каждые два года, приводя к значительному росту производительности. Это сопровождалось повышением тактовых частот процессоров, что напрямую увеличивало скорость выполнения операций. Например, в 1990-х и начале 2000-х годов процессорные частоты увеличивались с сотен мегагерц до нескольких гигагерц, что было главным показателем улучшения производительности.

Однако по мере достижения определённых физических пределов это масштабирование начало сталкиваться с проблемами. Рост тактовых частот привёл к усилению нагрева чипов и увеличению утечек тока через более тонкие слои изоляции в транзисторах. При дальнейшем уменьшении размеров транзисторов возникли проблемы с управлением тепловыми потоками, стабильностью работы и надёжностью устройств, особенно на нанометровых уровнях (ниже 22 нм). В результате стало практически невозможно продолжать увеличивать тактовые частоты без значительного повышения энергопотребления и тепловыделения.

Когда стало ясно, что увеличение тактовых частот достигло своего предела, индустрия переключила своё внимание на многоядерные архитектуры. Вместо увеличения производительности за счёт ускорения работы одного ядра, процессоры стали оснащаться несколькими ядрами, каждое из которых могло выполнять отдельные задачи. Переход к многоядерности позволил достичь значительного прироста производительности без необходимости повышать тактовые частоты. Такой подход дал возможность выполнять больше вычислительных операций параллельно, что значительно увеличило общую вычислительную мощность системы.

В многоядерных архитектурах каждое ядро функционирует независимо, что даёт возможность обрабатывать несколько потоков данных одновременно. Это открывает новые горизонты для многозадачных приложений и программного обеспечения, использующего параллельные вычисления, таких как научные расчёты, графические приложения и моделирование в реальном времени. В то же время важно отметить, что эффективность многоядерных процессоров напрямую зависит от способности программного обеспечения распределять задачи между ядрами, что требует дополнительных усилий от разработчиков.

Преимущество многоядерных систем заключается не только в увеличении вычислительной мощности, но и в повышении энергоэффективности. Разделение задач между ядрами позволяет снизить тепловыделение и уменьшить энергопотребление по сравнению с тем, как если бы использовался один высокочастотный процессор. Это особенно важно в современных условиях, когда энергопотребление стало критическим фактором в дизайне процессоров, особенно для мобильных устройств и дата-центров, где каждое снижение потребления энергии приводит к значительной экономии на охлаждении и питании.

Рост искусственного интеллекта и распределённых вычислений

Рост искусственного интеллекта (ИИ) и связанные с ним задачи обработки огромных массивов данных существенно изменили подходы к вычислениям в последние годы. Особенно востребованными стали распределённые вычисления, которые позволяют одновременно обрабатывать большие объёмы информации, распределяя вычислительные задачи между множеством узлов. Такие вычислительные инфраструктуры, состоящие из тысяч или даже миллионов процессоров, обеспечивают высокую производительность для приложений ИИ, которые требуют мощных вычислительных ресурсов для выполнения сложных математических операций, связанных с обучением и инференсом нейронных сетей.

Современные графические процессоры (GPU) и тензорные процессоры (TPU) играют ключевую роль в этих вычислительных системах. GPU изначально были разработаны для обработки графики, но их архитектура с большим количеством ядер отлично подходит для параллельных вычислений, необходимых в ИИ. Это делает их чрезвычайно эффективными для задач машинного обучения и глубокого обучения, таких как обучение нейросетей и обработка массивных датасетов. На сегодняшний день производительность современных GPU может достигать 4 TOPS/W (тераопераций в секунду на ватт), что делает их одними из самых эффективных инструментов для приложений ИИ.

Тензорные процессоры (TPU) — это специализированные интегральные схемы, созданные специально для ускорения задач, связанных с ИИ, в частности для работы с тензорными операциями, которые широко используются в нейронных сетях. Они демонстрируют несколько иную архитектуру, ориентированную на матричные операции, что позволяет достигать производительности до 2 TOPS/W. TPU, разработанные в первую очередь для задач Google, стали важным элементом для облачных вычислений и ИИ-решений, таких как Google Translate или систем распознавания изображений.

Эти специализированные процессоры существенно повышают эффективность обработки данных в приложениях ИИ, таких как ChatGPT-4, который использует массивные языковые модели для создания и анализа текста. Для успешного функционирования таких моделей требуется огромное количество вычислительных ресурсов, особенно на этапе обучения, когда обрабатываются миллиарды параметров и терабайты текстовых данных.

Однако наряду с ростом вычислительных мощностей значительно увеличиваются и требования к энергопотреблению. Современные серверы экзафлопсного уровня, которые обеспечивают производительность порядка 10^18 операций в секунду, требуют до 21 мегаватта энергии для своей работы. Это сравнимо с потреблением целого небольшого города.

Энергопотребление этих систем объясняется необходимостью постоянного охлаждения, поддержания питания тысяч процессоров и передачи данных между ними. Эффективность таких серверов составляет около 52 гигафлопс на ватт (ГФ/Вт), что демонстрирует впечатляющие результаты с точки зрения производительности, но ставит перед инженерами задачу дальнейшего повышения энергоэффективности.

Одним из ключевых направлений повышения эффективности в экзафлопсных системах является улучшение архитектуры процессоров и межсоединений между ними. Например, технологии кремниевых фотонных соединений позволяют снизить энергопотребление за счёт более эффективной передачи данных на больших расстояниях. Кроме того, разработки в области трёхмерных структур чипов и гибридных архитектур с использованием CPU, GPU и TPU могут помочь сократить энергозатраты.

Использование распределённых вычислений также способствует снижению общей нагрузки на отдельные узлы системы, что, в свою очередь, повышает их долговечность и снижает требования к охлаждению. В условиях роста популярности облачных вычислений, распределённые системы становятся ключевым элементом в обеспечении масштабируемости и гибкости ИИ-приложений, позволяя распределять задачи между различными центрами обработки данных.

Разрыв между производительностью и энергоэффективностью

Хотя производительность удваивается каждые 1,2 года, улучшение энергоэффективности происходит медленнее — только каждые 2,2 года. Если эта тенденция продолжится, то к следующему десятилетию для систем масштаба zeta потребуется около 500 МВт. Это делает очевидным необходимость повышения энергоэффективности в будущем.

Ключевые направления для повышения энергоэффективности

Эксперты выделяют три основных направления для улучшения энергоэффективности в будущих SoC:

- Оптимизация архитектуры процессоров: гибридные процессоры, сочетающие CPU и GPU, позволяют оптимизировать выполнение различных задач, что улучшает энергоэффективность. Архитектуры, специально разработанные для ИИ, также помогут эффективнее справляться с нагрузками, связанными с обработкой данных.

- Близость памяти к вычислительным блокам: Сокращение расстояния между памятью и процессорами позволяет минимизировать затраты энергии на перемещение данных. Это критически важно для энергоэффективности в высокопроизводительных вычислениях.

- Снижение коммуникационных накладных расходов: Оптимизация протоколов связи как внутри чипа, так и между компонентами позволяет снизить энергопотребление и повысить общую эффективность системы.

Новые архитектурные инновации: Чиплеты

Чтобы справиться с ограничениями на размер чипов, многие производители переходят к использованию технологии чиплетов. Это позволяет соединять несколько небольших микросхем, создавая более масштабируемые и эффективные процессоры.

Преимущества чиплетов включают:

- Гибкость: возможность настраивать конфигурации CPU/GPU под различные задачи и требования.

- Повторное использование памяти: крупные элементы памяти, такие как кэш L3, могут быть использованы в нескольких чиплетах.

- Экономия средств: возможность использования устаревших технологий для менее критичных компонентов, снижая затраты на производство.

Распределённая память и потребности ИИ

Для удовлетворения потребностей ИИ потребуется больше локализованной памяти, что минимизирует перемещение данных. Одним из решений является использование 3D-стекинга памяти, где память располагается поверх логических схем, что увеличивает скорость работы, но создаёт проблемы с управлением тепловыделением и питанием.

Пограничные устройства и энергетические ограничения

Пограничные устройства, такие как смартфоны, начинают обрабатывать данные локально, что снижает потребление энергии, необходимой для передачи данных на удалённые серверы. По мере роста сложности и объёма данных в таких устройствах важность энергоэффективности становится критически важной.

Близость памяти и разработка кэша

В современных вычислительных системах кэш-память играет критическую роль, обеспечивая эффективную связь между быстрой вычислительной мощностью процессоров и сравнительно медленной основной памятью. Кэш хранит часто используемые данные, что значительно ускоряет выполнение задач, повышает эффективность и общую производительность системы. С развитием технологий разработка новых решений для кэширования становится ещё более важной, чтобы удовлетворить возрастающие вычислительные потребности. На сегодняшний день шеститранзисторная (6T) SRAM, созданная на основе технологии CMOS, остаётся доминирующей технологией для кэш-памяти.

Рост спроса на кэш-память

Одна из ведущих компаний по производству микросхем указала на экспоненциальный рост спроса на кэш-память SRAM, особенно в секторах серверов и SoC для искусственного интеллекта (ИИ). Ожидается, что объём кэш-памяти в этих системах превысит 800 МБ в будущем, поскольку современные вычислительные системы всё больше зависят от быстрого доступа к данным для эффективной работы с большими наборами данных и сложными вычислениями.

Проблемы масштабирования SRAM

Несмотря на успехи в логических системах, масштабирование SRAM сталкивается с рядом серьёзных препятствий, особенно в контексте 5-нм и 3-нм узлов FinFET.

Эти проблемы включают:

- Высокую стоимость: В то время как логические элементы демонстрируют улучшение масштабирования площади до 28%, SRAM показывает лишь 5% улучшение. Это увеличивает стоимость на бит памяти.

- Ограниченная производительность: Ограничения литографии, металлические паразитные эффекты и физические ограничения транзисторов негативно влияют на эффективность и производство SRAM, делая его менее рентабельным.

- Литографические сложности: По мере уменьшения размеров транзисторов точность литографических процессов становится всё сложнее достигать.

- Металлические паразиты: Сопротивление и ёмкость межсоединений создают задержки и потери энергии, ограничивая возможности дальнейшего масштабирования.

- Физические ограничения транзисторов: При уменьшении размеров транзисторов увеличиваются проблемы утечек и снижается энергоэффективность.

Эти проблемы подчеркивают необходимость поиска альтернативных решений для кэш-памяти, которые могли бы сочетать высокую производительность с меньшей площадью и меньшими затратами энергии.

Инновации в области памяти: STT-MRAM и iRAM

В поисках более энергоэффективной альтернативы кэшу L3 SRAM, особое внимание привлекает технология STT-MRAM (магнитная память со спин-трансферным моментом). STT-MRAM обеспечивает низкую утечку и сниженное напряжение питания, а также экономию площади. Хотя её скорость записи несколько ниже, она по скорости чтения и выносливости не уступает SRAM. Время переключения менее одной наносекунды делает STT-MRAM перспективным кандидатом для замены SRAM.

Новая архитектура памяти, известная как интеллектуальная MRAM (iRAM), основана на STT-MRAM и предлагает улучшенные характеристики:

- Выносливость: iRAM обладает высокой выносливостью, почти как у SRAM, и системой ремонта в полевых условиях для продления срока службы.

- Производительность: Время записи iRAM составляет менее 30 нс, а чтение — около 3 нс, что делает её более энергоэффективной, чем SRAM.

- Надежность: iRAM работает при более низких напряжениях, устраняя утечки в режиме ожидания и обеспечивая долгосрочное хранение данных.

Преимущества для IoT и вычислений на границе

Энергоэффективность iRAM делает её особенно подходящей для приложений IoT, где устройства часто находятся в режиме ожидания или глубоком сне. Потребление энергии в этих режимах составляет всего 4% от энергопотребления в режиме ожидания SRAM и 0,02% от потребления в глубоком сне. iRAM также обеспечивает вдвое большую плотность записи, чем SRAM, при аналогичных размерах узлов, что делает её особенно подходящей для IoT-устройств.

Будущее iRAM: CIM и улучшение ИИ-приложений

Следующий этап развития iRAM включает функции вычислений в памяти (CIM), что позволит значительно повысить энергоэффективность приложений ИИ на границе. CIM-ускорители на базе iRAM могут улучшить эффективность (в TOPS/W) в 10 раз по сравнению с текущими реализациями на основе SRAM, открывая новые возможности для энергоэффективных ИИ-вычислений.

Развитие кэш-памяти и её близость к вычислительным блокам остаются критически важными для будущих высокопроизводительных вычислительных систем. Технологии, такие как iRAM и STT-MRAM, предлагают перспективные решения, обеспечивающие не только высокую производительность, но и улучшенную энергоэффективность для IoT и ИИ-решений.

Подписаться на почтовую рассылку / Авторам сотрудничество