Ускорители AMD Instinct MI300X выделяются в результатах MLPerf

Недавние тесты MLPerf Inference v4.1 подтвердили сильные позиции AMD на рынке аппаратного обеспечения для искусственного интеллекта (ИИ), особенно в сегменте инференса, благодаря высокой производительности их графических процессоров серии Instinct MI300X. Эти результаты стали важным шагом для AMD, демонстрируя её способность конкурировать с доминирующим лидером рынка NVIDIA, особенно в условиях растущих требований к вычислительным мощностям для ИИ.

Важность MLPerf Inference

MLPerf — это промышленный стандарт для тестирования производительности оборудования и программного обеспечения в задачах обучения и инференса моделей машинного обучения (ML). Тесты MLPerf Inference охватывают разнообразные сценарии применения, включая компьютерное зрение, обработку естественного языка и рекомендационные системы.

В версии 4.1 данные тесты снова подтвердили значимость MLPerf как инструмента для объективного сравнения различных решений на рынке ИИ. Высокие результаты в этих тестах свидетельствуют о способностях оборудования справляться с реальными задачами ИИ на высоком уровне производительности и с высокой эффективностью.

Серия GPU AMD Instinct MI300X

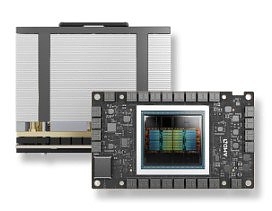

Instinct MI300X является флагманским продуктом AMD в области вычислений для ИИ и ускоренной обработки данных. Этот графический процессор был специально разработан для задач глубокого обучения, в частности для высокопроизводительных вычислений при инференсе сложных моделей. Он включает в себя множество аппаратных улучшений, таких как увеличенное количество ядер, высокоскоростная память и поддержка расширенных инструкций для работы с моделями машинного обучения.

Одним из ключевых факторов успеха MI300X является его архитектура CDNA (Compute DNA), которая оптимизирована для высокопроизводительных вычислений. В сочетании с эффективным управлением энергопотреблением и высокой пропускной способностью памяти, эта архитектура позволяет процессорам AMD конкурировать с лучшими решениями на рынке, включая такие флагманские продукты NVIDIA, как A100 и H100.

Сравнение с NVIDIA

NVIDIA долгое время занимала лидирующие позиции на рынке ИИ благодаря своим высокопроизводительным GPU, таким как A100 и H100, которые широко используются в дата-центрах и крупных инфраструктурах для инференса и обучения моделей. Однако с выпуском Instinct MI300X AMD существенно сократила разрыв в производительности и эффективности. В частности, MI300X продемонстрировал сопоставимые результаты в ряде тестов MLPerf, что подтверждает его способность решать сложные задачи ИИ.

MLPerf: Стандартизированный бенчмарк для ИИ

MLPerf является отраслевым стандартом для оценки производительности оборудования, предназначенного для ИИ. Благодаря этому бенчмарку компании могут сравнивать свои решения на базе различных моделей ИИ, предоставляя прозрачные и объективные данные о производительности. Это особенно важно в контексте растущих требований к аппаратным ресурсам для обработки больших языковых моделей (LLM) и других сложных вычислительных задач. В данном случае успех AMD подчеркивает её потенциал в конкуренции с признанными лидерами рынка, такими как NVIDIA, в ключевых областях ИИ.

Анализ производительности на примере LLaMA2-70B

AMD использовала в тестах модель LLaMA2-70B — мощную LLM для обработки естественного языка и инференса. Результаты тестов показали, что ускорители MI300X способны обеспечивать производительность, приближающуюся к системе NVIDIA DGX H100, при этом демонстрируя линейное масштабирование от одного до восьми GPU. Это подчеркивает не только вычислительную мощность, но и эффективность архитектуры MI300X в работе с крупными моделями ИИ.

В рамках тестирования рассматривались два сценария:

- Оффлайн-режим — максимизация пропускной способности при пакетной обработке данных.

- Серверный режим — задачи в реальном времени с низкими задержками.

Использование более 24 000 запросов из набора данных OpenORCA позволило AMD продемонстрировать возможности MI300X в условиях интенсивной нагрузки, где важны как пропускная способность, так и задержки.

Производительность AMD Instinct MI300X

В ходе тестирования, ускорители MI300X в паре с процессорами AMD EPYC показали отличные результаты в обоих сценариях.

Особенно выделялись следующие конфигурации:

- 8x MI300X с процессорами EPYC Genoa: Почти паритет с NVIDIA DGX H100, что демонстрирует конкурентоспособность решения AMD.

- 8x MI300X с будущими процессорами EPYC Turin: Улучшение производительности, особенно в реальном времени.

- Один MI300X: 192 ГБ HBM-памяти позволили одному GPU работать с полной моделью LLaMA2-70B, устранив необходимость разделения модели на несколько GPU. Это значительно улучшает производительность и снижает сложность системы.

Технические преимущества архитектуры и программного стека

MI300X обладает рядом архитектурных преимуществ, которые обеспечили его успех в тестах:

- Массовая память GPU: 192 ГБ HBM3 поддерживает полные модели, такие как LLaMA2-70B, исключая сетевые узкие места, часто возникающие при разделении модели на несколько GPU.

- FP8 точность: Поддержка FP8 обеспечивает высокую производительность с сохранением точности почти на уровне 100%, что критически важно для инференса больших моделей.

- Оптимизация программного стека: ROCm от AMD был усовершенствован для работы с моделями ИИ, включая оптимизации для работы с FP8 и квантованием, что позволило максимально использовать аппаратные ресурсы.

Сотрудничество с Dell

Успешные тесты на оборудовании Dell PowerEdge показали синергию между ускорителями AMD и инфраструктурой Dell, что делает платформу MI300X отличным решением для крупных центров обработки данных и периферийных приложений. Это сотрудничество подчеркивает важность комплексных решений для ИИ, сочетающих в себе высокопроизводительное железо и оптимизированные серверные платформы.

Взгляд в будущее: Поддержка более крупных моделей

Результаты тестов MLPerf закладывают основу для дальнейшего роста AMD на рынке ИИ. Следующие шаги включают поддержку более крупных моделей, таких как LLaMA 3.1 от Meta с 405 миллиардами параметров. Ускорители MI300X с их памятью и вычислительными мощностями будут играть ключевую роль в оптимальной работе таких моделей, что позволит уменьшить требования к серверной инфраструктуре и снизить затраты на их обслуживание.

Будущее поколение ускорителей Instinct

AMD продолжает активно развивать линейку ускорителей Instinct, стремясь предложить решения, которые соответствуют растущим потребностям в вычислительных мощностях для искусственного интеллекта (ИИ). В ближайших моделях, таких как Instinct MI300X, компания планирует увеличить ёмкость памяти, что является ключевым фактором для работы с большими языковыми моделями (LLM) и другими крупными моделями ИИ.

Увеличение объёма памяти также открывает возможности для обработки большего объёма данных в рамках одной вычислительной сессии, что критически важно при решении задач глубокого обучения, особенно когда речь идёт о трендовых технологиях, таких как генеративные модели.

Помимо увеличенной памяти, AMD активно работает над поддержкой вычислений с пониженной точностью данных, таких как FP8, INT8 и других типов. Этот подход становится всё более важным для ускорения процессов инференса, так как современные модели ИИ могут поддерживать вычисления с пониженной точностью, не теряя при этом качества предсказаний.

Пониженная точность снижает требования к объёму памяти и вычислительным ресурсам, позволяя более эффективно использовать доступные мощности и сокращать задержки в вычислениях. Это особенно важно для задач инференса, где требуется высокая скорость обработки данных при одновременной минимизации энергопотребления.

В связи с активным развитием аппаратной платформы AMD и улучшениями в её программном стеке, существует высокая вероятность того, что будущие результаты тестов MLPerf подтвердят дальнейший рост производительности и потенциала ускорителей Instinct.

AMD продолжает оптимизировать свои решения для работы с наиболее требовательными задачами ИИ, что может обеспечить ей ещё более конкурентоспособное положение на рынке. Учитывая, что MLPerf является одним из ключевых ориентиров для индустрии ИИ, эти результаты будут внимательно отслеживаться как производителями, так и потребителями высокопроизводительных вычислительных систем.

На фоне результатов последних бенчмарков, ускорители AMD Instinct MI300X демонстрируют высокую конкурентоспособность на рынке аппаратного обеспечения для ИИ, особенно в контексте работы с большими языковыми моделями (LLM), такими как GPT-3, GPT-4 и их аналогами, которые требуют огромных вычислительных ресурсов.

Эти модели являются основой для создания многих современных приложений, таких как системы генерации текста, понимания естественного языка, и рекомендательные системы. В этом контексте производительность Instinct MI300X на задачах глубокого обучения и инференса позволяет рассматривать AMD как серьёзного игрока на рынке решений для ИИ, способного конкурировать с NVIDIA, традиционным лидером в этой области.

Одним из ключевых преимуществ ускорителей AMD является их способность к линейному масштабированию. Это позволяет увеличивать производительность системы путём добавления новых GPU без значительного усложнения инфраструктуры. Гибкость решений AMD, в том числе поддержка различных типов данных и возможность масштабирования в зависимости от потребностей, делает их привлекательными для широкого круга пользователей — от исследовательских центров до крупных дата-центров, которые занимаются обработкой данных для ИИ.

Архитектура CDNA, на которой построены ускорители Instinct MI300X, является одним из ключевых факторов успеха этих решений. Она оптимизирована для высокопроизводительных вычислений и поддерживает самые современные требования к параллельной обработке данных, что делает её эффективной как для тренировки моделей, так и для инференса.

В дополнение к этому, AMD активно развивает программный стек ROCm (Radeon Open Compute), который предлагает инструменты и библиотеки для разработки приложений ИИ и машинного обучения. Этот стек обеспечивает совместимость с популярными фреймворками, такими как TensorFlow и PyTorch, что упрощает интеграцию решений AMD в существующие инфраструктуры.

Подписаться на почтовую рассылку / Авторам сотрудничество